在本教程中,我们将向您展示如何安装 Apache CentOS 7 服务器上的 Spark。 对于那些不知道的人, Apache Spark 是一个快速且通用的集群计算系统。 它提供 Java、Scala 和 Python 中的高级 API,以及支持整体执行图表的优化引擎。 它还支持一组丰富的高级工具,包括用于 SQL 和结构化信息处理的 Spark SQL、用于机器学习的 MLlib、用于图形处理的 GraphX 和 Spark Streaming。

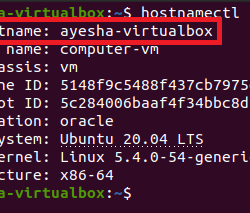

本文假设您至少具备 Linux 的基本知识,知道如何使用 shell,最重要的是,您将网站托管在自己的 VPS 上。 安装非常简单,假设您在 root 帐户下运行,如果不是,您可能需要添加 ‘sudo‘ 到命令以获取 root 权限。 我将向您展示逐步安装 Apache 在 CentOS 7 服务器上运行 Spark。

安装 Apache CentOS 7 上的 Spark

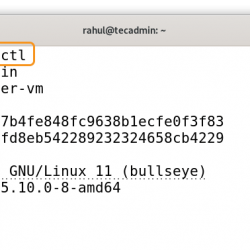

第 1 步。首先,让我们首先确保您的系统是最新的。

yum clean all yum -y install epel-release yum -y update

步骤 2. 安装 Java。

为要求安装 java 安装 apache-spark:

yum install java -y

安装后,检查java版本:

java -version

步骤 3. 安装 Scala。

Spark 在安装过程中安装了 Scala,所以我们只需要确保 Java 和 Python 存在即可:

wget https://www.scala-lang.org/files/archive/scala-2.10.1.tgz tar xvf scala-2.10.1.tgz sudo mv scala-2.10.1 /usr/lib sudo ln -s /usr/lib/scala-2.10.1 /usr/lib/scala PATH=$PATH:/usr/lib/scala/bin

安装后,检查 scala 版本:

scala -version

步骤 4. 安装 Apache 火花。

安装 Apache Spark 使用以下命令:

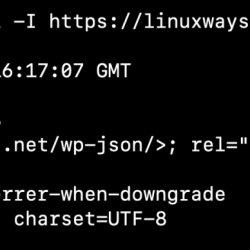

wget https://www-eu.apache.org/dist/spark/spark-2.2.1/spark-2.2.1-bin-hadoop2.7.tgz tar -xzf spark-2.2.1-bin-hadoop2.7.tgz SPARK_HOME=$HOME/spark-2.2.1-bin-hadoop2.7 PATH=$PATH:$SPARK_HOME/bin

在启动 spark 之前设置一些环境变量:

echo ' PATH=$PATH:/usr/lib/scala/bin' >> .bash_profile echo ' SPARK_HOME=$HOME/spark-2.2.1-bin-hadoop2.6' >> .bash_profile echo ' PATH=$PATH:$SPARK_HOME/bin' >> .bash_profile

可以手动启动独立的 Spark 集群,即在每个节点上执行启动脚本,或者简单地使用可用的 启动脚本. 为了测试,我们可以在同一台机器上运行主从守护进程:

./sbin/start-master.sh

步骤 5. 配置防火墙 Apache 火花。

firewall-cmd --permanent --zone=public --add-port=6066/tcp firewall-cmd --permanent --zone=public --add-port=7077/tcp firewall-cmd --permanent --zone=public --add-port=8080-8081/tcp firewall-cmd --reload

步骤 6. 访问 Apache 火花。

Apache 默认情况下,Spark 将在 HTTP 端口 7077 上可用。 打开您喜欢的浏览器并导航到 https://yourdomain.com:7077 要么 https://your-server-ip:7077 并完成所需的步骤以完成安装。

恭喜! 您已成功安装 Apache CentOS 7 上的 Spark。感谢您使用本教程进行安装 Apache CentOS 7 系统上的 Spark。 如需更多帮助或有用信息,我们建议您查看 官方 Apache 星火网站.